Hace dos años recibí una invitación para asistir al Open Summit del Digital Forensic Research Lab (#DFRLab), pero llegó la pandemia y no se armó. Lo que sí sucedió es que tomé todo los cursos en línea que el laboratorio –parte del Atlantic Council– ofreció sobre análisis y estudio forense digital. Dos años después, se organizó la cumbre en Bruselas y ahí estuve.

Aunque no sabía muy bien qué esperar porque se habla de periodismo, inteligencia artificial, áreas grises y demás, me apunté para aprender, escuchar, pero sobre todo, para reflexionar. Sigo rumiando los retos digitales que nos esperan en términos de desinformación, fakenews, apertura y política. Sin embargo, el lugar en el que se realizaron las conferencias estuvo siempre bajo un halo de grandeza y trascendencia: el 306/Open Summit tuvo lugar en la primera sede del parlamento europeo.

No creo que el lugar hay sido solo sucedáneo, pero sí con el objetivo de dejar claro que ahí se reúnen los tomadores de decisiones.

Nos movemos en áreas grises

Las herramientas utilizadas para el análisis forense en temas digitales suelen ser de código abierto <open source> y, por lo tanto, las investigaciones caen en áreas grises. El arranque del evento consistió en examinar el tema ético de quienes se dedican a hacer estudios forenses.

La reputación de los medios y de las personas se basa en la ética de su actuar. Partiendo de esta base, lo ‘abierto’, del open source significa –a veces– exponer accidentalmente información sensible, hacer mal uso de metodologías o tecnologías, desvirtuar el crowdsourcing y la amplificación que eso conlleva. En este sentido, mientras que el DFRLab se define a sí mismo como un ente de buena voluntad, es necesario explicar las razones detrás del análisis forense. Andy Carvin, el director editorial del DFRLab, repitió más de una vez que:

Poor explanations are seen as unethical

¿Dónde están las áreas grises? Por poner un ejemplo, pero el software de reconocimiento facial tendrá muy buenos objetivos, pero también ha sembrado desinformación como en el atentado del Maratón de Boston, en 2013. Algunos activistas que colaboraron haciendo investigación forense digital –y con las mejores intenciones– señalaron por error a una persona que cumplía con ciertas características físicas. Esto provocó la propagación de la desinformación y el apuntalamiento a una persona que no tenía ni vela en el entierro.

Segundo aprendizaje en esta línea:

Be careful what you are paying attention to. You might spread misinformation.

‘Todos somos buenos’

Durante los dos días que duró el evento un par de ideas dominaron la agenda, una es que la invasión rusa a Ucrania es lo más malo que le ha pasado al mundo.

Y la otra idea es que quienes participábamos éramos los buenos de la película. No lo dudo y menos luego de estudiar cómo en África se utilizan grupos de WhatsApp para desequilibrar las elecciones, o cómo las personas crean personalidades completas en redes sociales para sembrar desinformar sobre el SarsCov19.

Sí, el mundo necesita más sherlocks, pero, retomando las áreas grises previamente discutidas, me parece que a los casi 120 asistentes de 114 países, no les falta malicia, pero sí adoptar y aceptar que el mundo es gris para frenar, de tajo, la desinformación. De hecho, con esto en mente, tengo una idea arriesgada: no necesitamos más policy makers, el mundo necesita makers of policies.

Una idea arbitraria

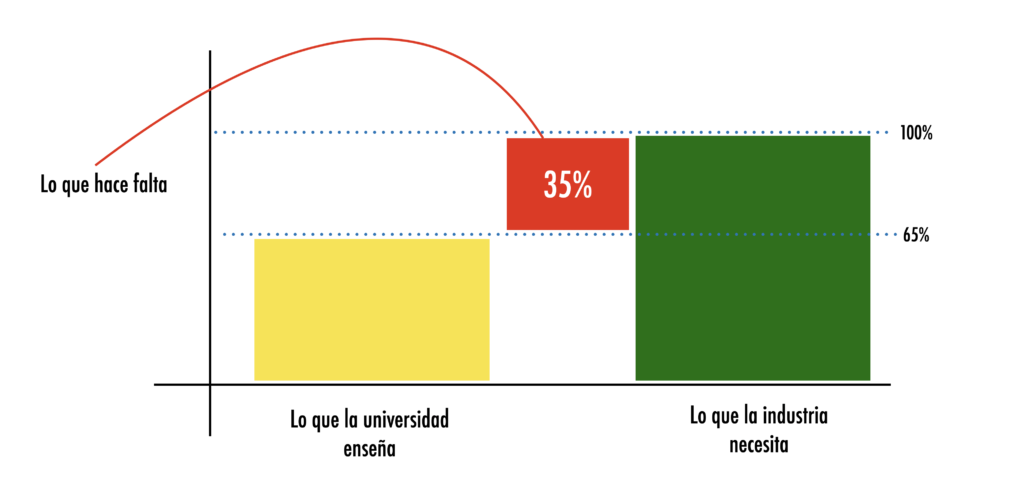

En varios foros he dicho que las universidades se mueven muy lento en comparación a la vertiginosa rapidez con la que el mundo avanza. De hecho, la universidad de Bentley lo mostró desde 2014.

En el tema de crear leyes y políticas, el mundo es un gran elefante blanco, muy parecido a las universidades. Por ejemplo, durante el 360/Open Summit, Facebook –Meta– dio una charla muy entretenida ‘To CIB or not to CIB’. El acrónimo CIB se refiere a coordinated unauthentic behaviour y es la creación de perfiles falsos en redes sociales con fines de engaño. Hay perfiles muy elaborados y otros no tanto.

El término CIB fue acuñado en 2017 por Facebook y al finalizar su conferencia, los representantes de la plataforma digital dijeron que trabajan de cerca con las autoridades para desarrollar políticas adecuadas contra los engaños.

Este, justo, es el quid: Meta (o cualquier empresa de tecnología) se da cuenta de que algo y lo regula, lo pasa a legisladores, quienes lo discuten sin saber del tema y entran, además muchos otros intereses en juego. Entonces, mientras que las empresas se dan cuenta de algo y se crean las políticas adecuadas, el mundo avanza, el uso negativo que se le da a toda la tecnología avanza y los agravados siempre es la gente. Por eso la idea loca que tengo, que podría tacharse de totalitarismo, consiste en desarrollar makers of policies: gente versada que entiende las áreas grises (y las ha vivido) para regular la tecnología y su uso antes de que siga haciendo daño.

Algunos conceptos e ideas para reflexionar

1. Debunk(ing). Mostrar la falsedad de algo de manera instantánea. Durante una de las sesiones prácticas los fellows del DFRLab, pusieron un ejemplo muy clásico. Se encuentra una cuenta de Twitter que está difundiendo una supuesta carta oficial en la que el gobierno ucraniano dice que hay que bombardear la fronteras con armas químicas. La carta tiene todos los rasgos de documentos apócrifos difundidos por los rusos durante la guerra. ¿Qué harías?

Fuera del debate que esto pueda generar, el término es interesante porque consiste en tomar las riendas y exponer de manera clara, concisa y directa que algo es falso. ¿Qué pasó durante la sesión? Solo yo propuse señalar el documento como falso. Los demás argumentaron que debían dejarlo vivir, si crecía, ya lo frenaban. Pero el siguiente caso muestra que no se puede frenar la viralidad.

2. Oxygen of amplification. “The choices reporters and editors make about what to cover and how to cover it play a key part in regulating the amount of oxygen supplied to the falsehoods, antagonisms, and manipulations that threaten to overrun the contemporary media ecosystem -and, simultaneously, threaten to undermine democratic discourse more broadly”.

Entonces, el dilema es si decir algo o no, porque puede ‘oxigenarse’. El mismo laboratorio identificó que, por no hacer a tiempo un debunking, la historia de que los rusos usaron armas químicas en Ucrania tuvo un alcance global retomado por varios medios de comunicación.

Empezó con un simple tuit, sencillo, de una cuenta poco conocida que un medio local retomó diciendo que no tenían certeza de la fuente. Un portal europeo pensó que era noticia y lo propago, con ciertas licencias creativas. En menos de 12 horas, un medio estadounidense de relevancia internacional tomó la historia y embarraron al alcalde de dicha ciudad sin tener certeza del uso de armas químicas. Todo fue falso.

¿Cuál es el rol que juegan los editores y periodistas para dar aire al fuego? Es interesante la reflexión.

3. Educated guesses. Se trata de una suposición basada en el nivel conocimiento y juicio de una persona específica, por lo que puede ser correcta. Traducción: creo que sé lo suficiente, por lo que es probable que esté en lo correcto, y por tanto es verdad. Se parece un poco a la idea de fake knowledge que expuse hace algún tiempo. Es como confiar a ciegas en las corazonadas que tenemos, solemos estar en lo correcto, pero casi siempre faltan datos.

Justo, el trabajo de un digital sherlock y periodista posmoderno consiste en eso, en hacer análisis forense para tener certeza, y no solo suposiciones estudiadas, que oxigenen la sarta de falsedades que se esparcen por el mundo por la falta de políticas adecuadas.

Una última certeza

La mayoría de la desinformación viene de la familia y los amigos, estamos programados para creerles, y por lo tanto somos el eslabón más débil para la transmisión de la desinformación, pero también el más fuerte para frenarla.